在 2016 年世界经济论坛(WEF)达沃斯年会上,全球菁英聚焦在一项“下一件大事”的议题:“第四次工业革命”即将到来!推动第四次工业革命的主要动力就是人工智能(AI)。此后至今, AI 两个大字铺天盖地而来,不论是在科研圈还是行业里都成了一门显学,大众也实际体验到 AI 带来的不可思议。

随着世界各国、行业巨擘、初创公司积极拥抱 AI ,掀起了资料科学家、机器学习专家等人才的流动潮,尤其是不少重量级人物的异动,透露出大企业正在进行激烈的抢人大作战,去年,有“苹果 Swift 语言之父”美誉的 Chris Lattner,离开苹果加入特斯拉协助开发自动驾驶软体,待了半年随即加入 Google Brain 团队。

今年 2 月底,亚马逊 Alexa AI 负责人 Ashwin Ram 跳槽谷歌,成为谷歌云部门 AI 技术总监。4 月,曾任 Google 人工智慧暨搜寻部门负责人的 John Giannandrea 宣布离职投入苹果麾下,担任苹果机器学习及 AI 战略总监。8月,前特斯拉首席工程师、负责 Model 3 生产的 Doug Field,重回苹果怀抱,参与研发自驾车 Project Titan 计划,外电甚至爆出,2017 年至今特斯拉已有多达 46 位特斯拉员工跳槽到苹果,让特斯拉创办人马斯克感到痛苦。

在国内高阶人才跳槽的情况也不惶多让,前亚马逊资深主任科学家任小枫在去年跳槽阿里巴巴,担任人工智慧核心团队 iDST 首席科学家和副院长,另外张潼从百度转战腾讯担任 AI Lab 主任,以及百度不少 AI 相关技术的高管或专家离职选择自行创业。近期,则有一则 AI 大明星的异动同样受到关注,那就是新任 NVIDIA 机器学习研究总监的 Anima Anandkumar。

Animashree Anandkumar将参加 10 月 27 日在北京举办全球科技青年论坛

最闪亮的 AI 明星

过去,Anima Anandkumar在市值一度突破万亿美元的亚马逊担任 AWS 深度学习主任科学家,是什么原因让她从以软件、网络服务为主的公司,转而加入硬件公司英伟达?

“我的任务是带领英伟达的研究范围进一步扩大及成长,同时与大学建立伙伴关系,” Anima Anandkumar 接受 DT 君专访透露她新工作的内容及方向。

过去产业对 AI 投入的关注较少,因此近年 AI 再度兴起后,许多公司都是从科研领域寻找高手,在 亚马逊成为 Anima Anandkumar 第一个进到行业里的工作之前,她是加利福尼亚大学尔湾分校(UC Irvine)电机工程与资讯科学系(EECS Department)的助理教授,研究兴趣包括大规模机器学习、非凸优化(non-convex optimization)和高维统计。

2010 年左右是大数据革命的开始,大家试图找出能够大规模处理数据的算法,做出有用的推论,她开始研究潜在变数(latent variables),“当资讯不够多的时候,我们就无法发现一些被隐藏的因素,但是如果只是受限于运算能力的话,其实是可以被辨识出来的”。而张量(tensor)研究领域就成了一个解法,“如果考虑一对变量之间的关系,这是成对的相关性,但是如果想考虑 3 倍或更高倍数之间的关系,这就需要张量,”她说。

图 | Animashree Anandkumar

“我的目标是让世界上每个人都可以使用机器学习,不必是机器学习、应用领域或编程方面的专家,缩小从制定理论到技术落地的鸿沟”。因此,让技术易用、而且可以实际落地就成了她的使命,她在 AWS 期间一直领导张量算法的开发和分析,加速那些执行在 AWS 上的应用、服务的效率,并且开发多模态处理算法,可以同时处理文本、图像和其他大规模模态,为 Apache MXNet 提高了可编程性和易用性。

她心中的英伟达是做什么的公司?

众所皆知,亚马逊无疑是 AI 技术最领先的公司之一,英伟达更是因 AI 而咸鱼翻生,世界上众多的 AI 模型背后都是仰赖 GPU 强劲的算力来运作,因此被喻为是“提供 AI 军火的弹药商”,论技术实力同样是位在 AI 领先群里,只不过软硬件公司的企业文化向来很不同,两家公司的商业模式也差异颇大。

“为什么会在这个时刻加入英伟达?对你来说,英伟达是一家什么样的公司?”,DT 君提问。

“NVIDIA是一家非常具有创新精神的公司。如果你看它的轨迹,从一个以图形加速器为根基的公司,掀起了高性能计算的革命,再到现在的人工智能,于深度学习起了关键作用,这真是太神奇了!唯有当一家公司具备创新的DNA,才有可能实现这一点,”她自信的说。

她也指出,英伟达不仅仅是一家硬件公司,“CUDA 函式库(library)的开发一直是扩展深度学习的关键。CUDA primitives 也与我的张量研究有关。”几年前,Anima Anandkumar 与英伟达研究人员 Cris Cecka 一起为张量缩并(tensor contraction)的操作构建了扩展的 BLAS 内核。加入新東家之後,她期许为 CUDA 中的张量代数(tensor algebraic)运算提供更多支持,藉此能夠创造更高效的张量神经网络架构。

到英伟达之后要做什么?

由于英伟达目前的重心除了 AI 之外,就是自动驾驶,因此让人好奇她是否会参与自动驾驶方案开发,张量研究也能应用在自动驾驶领域吗?面对 DT 君的提问,她回答:张量可以广泛适用,因此许多机器学习框架都以张量来命名,像是谷歌的 TensorFlow、英伟达的 Tensor Cores 等。简单来说,张量是多维阵列,但从数学上讲,它们远不止于此,相较于矩阵,张量可以用更丰富的方式操作,例如矩阵运算只能在两个方向上:左乘或右乘,但是你可以用无数的方式缩并张量。

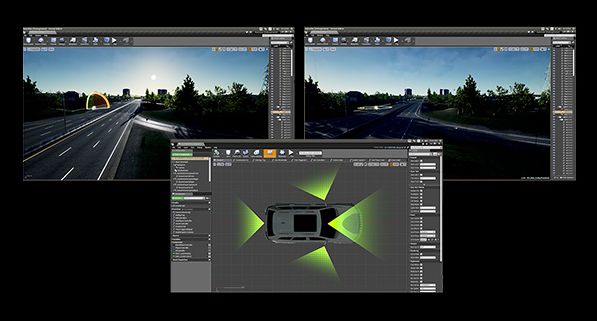

图丨NVIDIA DRIVE Constellation(来源:NVIDIA )

她进一步指出,我们现今运行的神经网络类别只要它只涉及矩阵运算,丰富的张量运算就可以扩展到其中。“我的研究表明在计算机视觉和时间序列预测等各种领域,张量化的神经网络更加结实、紧凑,并且可以更通用。我期待在 NVIDIA 进一步开展有关张量和其他主题的研究。”

从张量算法到机器人,她都很拿手

现在的她,除了NVIDIA 机器学习研究总监,还有另一个身份—加州理工学院(Caltech)计算和数学科学系的资助讲座教授(endowed chair professorship),并深度参与 Caltech 旗下自动化系统与科技中心(CAST)和 AI4science 计划项目。

中华养生网